Veri, dünyamızın itici güçlerinden biri. Günlük hayatımızın her yönü veri etrafında dönüyor. Veri olmadan, bugün sahip olduğumuz teknolojik büyümeye ulaşmak imkansızdır. Veri, sektörden bağımsız olarak her kuruluş için çok önemlidir. En önde gelen kuruluşların veri bankaları ve veri gölleri vardır. Daha iyi bir içgörü elde etmek için verileri alır ve analiz ederler. Bazen verileri dışarıdan toplamak, çevrimiçi olarak toplamak gerekir. Bu durum, web kazımanın daha iyi parladığı yerdir. Birçok veri bilimi topluluğu, çeşitli analizler için farklı veri biçimlerini seçmek üzere etik web kazımayı teşvik etmektedir. İlerleyen bölümlerde web kazıma ve en iyi python web kazıma araçlarını tartışacağız.

Python web kazıma araçları hakkında daha fazla bilgi edinmek için herhangi bir bölüme atlamaktan çekinmeyin!

Basit bir ifadeyle, ekran kazıma olarak da bilinen web kazıma, çevrimiçi olarak çeşitli kaynaklardan büyük miktarda veri çıkarmaktır. İnsan etkileşimi olmadan otomatikleştirilmiş bir süreçtir. Çoğu insan web kazıma ile ilgili gerçek süreç hakkında genellikle yanlış yönlendirilir. Web kazıma işlemi, hedeflenen bir kaynaktan veri çıkarmak ve verileri düzenlemektir. Ekran kazıma işlemi gerçekleştirdiğinizde veriler yapılandırılmamış bir formattadır, yani etiketlenmiş veri yoktur. Web verisi çıkarma işlemi, bu yapılandırılmamış verilerin bir veri çerçevesi kullanılarak yapılandırılmış verilere dönüştürülmesini de içerir.

Web kazıma işlemini gerçekleştirmenin, sıfırdan otomatik bir komut dosyası oluşturmak veya Twitter, Facebook ve Reddit gibi web sitelerini kazımak için bir API aracı kullanmak gibi çeşitli yolları vardır. Bazı web sitelerinin sınırlı miktarda veriyi kazımaya izin veren özel API'leri vardır, bazılarının ise yoktur. Bu senaryolarda, web kazıma işlemini gerçekleştirmek, bu web sitelerinden veri çıkarmak için en iyisidir.

Web kazıma, bir kazıyıcı ve bir tarayıcı olmak üzere iki bölümden oluşur. Kazıyıcı, bağlantıları takip ederek gerekli verileri tanımlamaya yardımcı olan bir makine öğrenme algoritmasıdır. Crawler ise hedeften veri çıkarmak için kullanılan bir araçtır. Kullanıcılar hem kazıyıcıyı hem de tarayıcıyı değiştirebilir.

Teknik olarak web kazıma işlemi tohum URL'sini besleyerek başlar. Bu URL'ler verilere açılan bir kapı görevi görür. Kazıyıcı, web sitelerinin HTML kısmına erişebileceği yere ulaşana kadar bu URL'leri takip eder. Belirtildiği gibi, tarayıcı HTML verilerini ve XML belgelerini gözden geçiren, verileri kazıyan ve sonucu kullanıcı tanımlı bir formatta, genellikle Excel elektronik tablosu veya CSV (Virgülle ayrılmış dosya) formatında çıkaran bir araçtır. Diğer yapılandırma ise JSON dosyasıdır. Bu JSON dosyası, tek seferlik kazıma yerine tüm süreci otomatikleştirmek için faydalıdır.

Gereksinimlere dayalı olarak, web kazıyıcılar dört türe ayrılabilir, yani:

Kendi kendine komut dosyası oluşturan web kazıyıcı - Bu tür, seçtiğiniz herhangi bir programlama dilini kullanarak web kazıyıcınızı oluşturmaya dayanır. En popüler olanı python'dur. Bu yaklaşım için ileri düzeyde programlama bilgisine sahip olmak gerekir.

Önceden komut dosyası oluşturulmuş web kazıyıcı -Butür zaten komut dosyası oluşturulmuş bir web kazıyıcı kullanır. Bu, web kazıma işlemini başlatmak için çevrimiçi olarak indirilebilir. Önceden oluşturulmuş web kazıyıcı, gereksinimlerinize göre seçeneği değiştirmenize olanak tanır. Çok az veya hiç programlama bilgisi gerekmez.

Tarayıcı uzantısı - Bazı web kazıma API'leri bir tarayıcı uzantısı (eklenti) olarak mevcuttur. Varsayılan tarayıcı ile etkinleştirmeniz ve Excel elektronik tablosu veya CSV dosyası gibi çıkarılan verileri kaydetmek için veritabanı konumunu belirtmeniz yeterlidir.

Bulut tabanlı web kazıyıcı - Çok az sayıda bulut tabanlı web kazıyıcı vardır. Bu web kazıyıcılar, web kazıyıcıyı satın aldığınız şirket tarafından tutulan bir bulut sunucusuna dayalı olarak çalıştırılır. Ana avantajı hesaplama kaynağıdır. Bulut tabanlı bir web kazıyıcı ile, web kazıma zorlu bir kaynaktır, böylece bilgisayarınız diğer temel görevlere odaklanabilir.

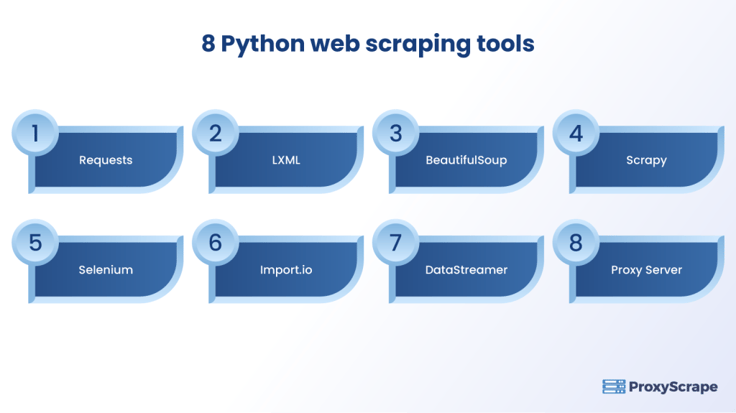

Python, genellikle yeni başlayanların programlama alanındaki yolculuklarına başlamalarına yardımcı olan yüksek kullanıcı okunabilirliği nedeniyle yaygın olarak en iyi başlangıç programlama dili olarak kabul edilmektedir. Aynı nedenle, python web kazıma için çok uygundur. En iyisi olduğunu düşündüğümüz altı python web kazıma kütüphanesi ve aracı vardır. NOT: Bu araçlardan bazıları web kazıma sürecinde belirli bir işleve sahip python kütüphanelerinden oluşur

Muhtemelen python'daki en temel ve standart kütüphane, esas olarak en iyi python web kazıma araçlarından biri olarak kullanılır. Web kazıma işlemindeki ilk adım, verileri almak için hedef web sitesinin sunucusundan HTML verilerini "istemektir". İstek kütüphanesine yapılan istek GET ve POST'tur. İki ana dezavantajı, hedeflenen web sitesi saf javascript'ten yapıldığında istek kütüphanesinin verimli bir şekilde kullanılamaması ve HTML'yi ayrıştırmak için kullanılamamasıdır.

İşte requests kütüphanesini yüklemek için python kodu:

i̇thalat talepleri̇

data =requests.request("GET", "https://www.example.com")

VeriNOT: Sadece Juypter notebook veya Google Collab kullanarak istekleri içe aktarabilirsiniz. Windows, Linux veya macOS üzerinde CMD kullanıyorsanız, pip yöntemini kullanarak istekleri yükleyebilirsiniz. İstekleri yüklemek için python kodu "pipinstall requests" şeklindedir. Hatırlanması gereken en önemli şey, python'un "urllib" ve "urllib2 " ile birlikte geldiğidir. Urllib bir istek yerine kullanılabilir, ancak dezavantajı bazen hem urllib hem de urllib2 kullanmak gerekir, bu da programlama komut dosyasının karmaşıklığının artmasına neden olur.

Bu kütüphane, istek kütüphanesinin güncellenmiş bir sürümüdür. LXML kütüphanesi, HTML'yi ayrıştıran istek kütüphanesinin dezavantajını ortadan kaldırır. LXML kütüphanesi, yüksek performans ve verimlilikle büyük miktarda veriyi hızlı bir şekilde çıkarabilir. Hem istekleri hem de LXML'yi birleştirmek HTML'den veri çıkarmak için en iyisidir.

BeautifulSoup muhtemelen python web kazıma araçlarından biri olarak gidilecek kütüphanedir çünkü yeni başlayanlar ve uzmanlar için çalışması daha kolaydır. BeautifulSoup kullanmanın ana avantajı, kötü tasarlanmış HTML hakkında endişelenmenize gerek olmamasıdır. BeautifulSoup ve isteği birleştirmek de web kazıma araçlarında yaygındır. Dezavantajı ise LXML'e kıyasla daha yavaş olmasıdır. BeautifulSoup'un LXML ayrıştırıcı ile birlikte kullanılması tavsiye edilir. BeautifulSoup'u yüklemek için python kodu "pip install BeautifulSoup" şeklindedir.

Scrapy 'yi web kazımanın kahramanı olarak adlandırmak güvenlidir. Scrapy bir python kütüphanesi değil, tam teşekküllü bir web kazıma çerçevesidir. Arka uçta Scrapy, kaynağa aynı anda birden fazla HTTP isteği gönderebilen bir bottan oluşur. Scrapy web kazıma için sağlam bir çerçeve olsa da, işlevselliğini artırmak için eklentiler ekleyebilirsiniz. Scrapy'nin ana dezavantajı, selenium gibi (ilerleyen bölümde göreceğimiz) javascript'i işleme yeteneğine sahip olmamasıdır. Scrapy, dinamik bir web sitesinden veri çıkarmayı destekleyen herhangi bir kütüphane kullanarak bu dezavantajın üstesinden gelebilir.

Selenium, Jason Huggins tarafından web uygulamalarının otomatik olarak test edilmesi için oluşturulmuştur. Scrapy'nin Javascript sayfalarını kolayca işleyememesinin dezavantajı, Selenium'un en çok parladığı yerdir. Selenium dinamik web sayfalarını kazıyabildiğinden, bu web sayfasından veri kazımak da en iyisidir. Ancak Selenium'un küçük ölçekli projeler üzerinde çalışırken ve zamanın önemli olmadığı durumlarda kullanılması önerilir. Selenium, hedeflenen kaynağın her sayfasında javascript çalıştırdığından, diğer python kütüphanelerine ve çerçevelerine kıyasla yavaş olma eğilimindedir.

Web sitelerinin hızla değiştiği ve daha karmaşık hale geldiği doğrudur. Bir e-ticaret web sitesinden veri kazımak gibi daha büyük ölçekte web kazıma daha zor hale geliyor.

Ancak import.io 'nun bir çözümü var. Web kazıma alanındaki en son teknoloji ile aynı anda birden fazla web sitesini gecikme olmadan kazıyabilirsiniz. import.io ile ilgili en iyi şey, kazınan verileri otomatik olarak kontrol edebilen ve düzenli aralıklarla QA denetimleri yapabilen bir araç olmasıdır.

Bu özellik, null ve yinelenen değerlerin kazınmasını önlemek için kullanılabilir. Ürün ayrıntıları, sıralamalar, incelemeler, Soru-Cevap ve ürün kullanılabilirliği gibi çeşitli veri türlerini kazıyabilirsiniz.

Bir sosyal medya pazarlamacısıysanız, datastreamer sosyal medya web sitelerinden çok sayıda genel veriyi kazımanız için en iyi araçtır. DataStreamer ile yapılandırılmamış verileri tek bir API ile entegre edebilirsiniz.

DataStreamer ile veri hattınızı saniyede 56.000'den fazla içerik ve 10.000 zenginleştirme ile besleyebilirsiniz. Verilerinizi, yanıtlanmasını istediğiniz sorulara göre filtreleyerek ve toplayarak özelleştirin.

Proxy gerçek bir python aracı değildir ancak web kazıma için gereklidir. Yukarıda belirtildiği gibi, bazı web siteleri web sayfalarından veri çıkarmanıza izin vermediğinden, web kazıma işleminin dikkatli bir şekilde yapılması gerekir. Bunu yaparsanız, büyük olasılıkla yerel IP adresinizi engelleyeceklerdir. Bunu önlemek için, bir proxy IP adresinizi maskeler ve sizi çevrimiçi anonim hale getirir.

ProxyScrape çevrimiçi en popüler ve güvenilir proxy sağlayıcılarından biridir. Üç proxy hizmeti arasında özel veri merkezi proxy sunucuları, konut proxy sunucuları ve premium proxy sunucuları bulunmaktadır. Peki, web kazıma için en iyi HTTP pro xy için mümkün olan en iyi çözüm nedir? Bu soruyu yanıtlamadan önce, her bir proxy sunucusunun özelliklerini görmek en iyisidir.

Özel bir veri merkezi proxy'si analiz amacıyla çeşitli sunuculardan büyük miktarda veri (boyut açısından) akışı gibi yüksek hızlı çevrimiçi görevler için en uygunudur. Bu, kuruluşların kısa sürede büyük miktarda veri iletmek için özel proxy'leri seçmelerinin ana nedenlerinden biridir.

Özel bir veri merkezi proxy'si, sınırsız bant genişliği ve eşzamanlı bağlantılar, kolay iletişim için özel HTTP proxy'leri ve daha fazla güvenlik için IP kimlik doğrulaması gibi çeşitli özelliklere sahiptir. 99,9 çalışma süresi ile, özel veri merkezinin herhangi bir oturum sırasında her zaman çalışacağından emin olabilirsiniz. Son olarak, ProxyScrape mükemmel müşteri hizmetleri sunar ve sorununuzu 24-48 iş saati içinde çözmenize yardımcı olur.

Sırada bir konut proxy'si. Konut, her genel tüketici için gidilecek bir proxy'dir. Bunun ana nedeni, bir konut proxy'sinin IP adresinin ISP tarafından sağlanan IP adresine benzemesidir. Bu, hedef sunucudan verilerine erişmek için izin almanın normalden daha kolay olacağı anlamına gelir.

ProxyScrape'un konut proxy'sinin diğer bir özelliği de dönen bir özelliktir. Dönen proxy, hesabınızın kalıcı olarak yasaklanmasını önlemenize yardımcı olur çünkü konut proxy'niz IP adresinizi dinamik olarak değiştirerek hedef sunucunun proxy kullanıp kullanmadığınızı kontrol etmesini zorlaştırır.

Bunun dışında, bir konut proxy'sinin diğer özellikleri şunlardır: eşzamanlı bağlantıyla birlikte sınırsız bant genişliği, özel HTTP / s proxy'leri, proxy havuzundaki 7 milyondan fazla proxy nedeniyle herhangi bir zaman oturumunda proxy'ler, daha fazla güvenlik için kullanıcı adı ve şifre kimlik doğrulaması ve son olarak, ülke sunucusunu değiştirme yeteneği. Ülke kodunu kullanıcı adı kimlik doğrulamasına ekleyerek istediğiniz sunucuyu seçebilirsiniz.

Sonuncusu ise premium proxy. Premium proxy'ler özel veri merkezi proxy'leri ile aynıdır. İşlevsellik aynı kalır. Temel fark erişilebilirliktir. Premium proxy'lerde, proxy listesi (proxy'leri içeren liste) ProxyScrapeağındaki her kullanıcı için kullanılabilir hale getirilir. Bu nedenle premium proxy'ler özel veri merkezi proxy'lerinden daha ucuzdur.

Peki, web kazıma için en iyi HTTP proxy için mümkün olan en iyi çözüm nedir? Cevap "konut pro xy'si" olacaktır. Nedeni basittir. Yukarıda belirtildiği gibi, konut proxy'si dönen bir proxy'dir, yani IP adresiniz belirli bir süre boyunca dinamik olarak değiştirilir ve bu da IP bloğu almadan küçük bir zaman dilimi içinde çok sayıda istek göndererek sunucuyu kandırmaya yardımcı olabilir.

Daha sonra, en iyi şey proxy sunucusunu ülkeye göre değiştirmek olacaktır. IP kimlik doğrulamasının veya kullanıcı adı ve parola kimlik doğrulamasının sonuna ülke ISO_CODE'unu eklemeniz yeterlidir.

Önerilen Okumalar:

Web kazıma, her veri bilimci ve analist için önemli bir araçtır. Bu araç sayesinde veri bilimciler veriler hakkında daha iyi bilgiler edinebilir ve günümüz dünyasındaki sorunlara daha iyi çözümler sunabilir. Eğer bir SEO/dijital pazarlamacı iseniz, Python web kazıma araçları bir zorunluluktur. Python web kazıma araçları, çok fazla zaman kazanmanıza ve çok ihtiyaç duyduğunuz verileri herhangi bir zorluk yaşamadan kolayca toplamanıza yardımcı olur. Bu makale "En iyi 8 Python web kazıma aracı" hakkında yeterli bilgi vermeyi umuyor

YASAL UYARI: Bu makale kesinlikle öğrenme amaçlıdır. Uygun yönergeleri izlemeden web kazıma yapmak yasa dışı olabilir. Bu makale, herhangi bir şekilde veya biçimde yasadışı web kazımayı desteklemez.